big.LITTLE の制御ソフトウェア技術を整理してみよう (その2)

前回の続き。前回は主に用語を整理したので続いて中身の整理。よく知らないものはその都度調べていこう。

まずは IKS について。【後藤弘茂のWeekly海外ニュース】2014年にはメジャーになるARMの省電力技術「big.LITTLE」 - PC Watch からポイントを拾っていくと、

IKSの利点は、OSのスケジューラに変更を加えず、スケジューラの下で動作する2,000行くらいのコードで実現していることだ。IKSでは、OSのスケジューラからはCPUコアは通常の対称型のSMP(Symmetric Multi-Processor)構成に見えているが、ハードウェア的には非対称なAMP(Asymmetric Multiple Processor)構成となる。

LinaroのIn-Kernel Switcher(IKS)は、CPUコアを切り替える際に、CPU負荷に応じる。切り替えの遷移ポイントの決定には、CPUコアの電圧と動作周波数を切り替える「DVFS(Dynamic Voltage and Frequency Scaling)」の仕組みを使ってる。LinuxのCPUFreq Governorサブシステムが、CPU使用率をモニタしてCPUの動作周波数を遷移させる。IKSは、DVFSが一定のポイントに達した時にCPUコアをスイッチさせる。

そのため、IKSでは、バーチャルOPP(Operating Performance Point)を設定して、Cortex-A7とCortex-A15それぞれの実際のDVFSポイントにマップしている。OSから見えるのは、バーチャルOPPとなる。

こうした仕組みを取っているため、IKSではGovernorサブシステムの味付けで、ある程度振るまいを変えることができる。パフォーマンス優先のGovernorなら、より多くbigコアに割り振られることが多くなる。逆に省電力優先のGovernorをベンダーが選択すると、よりLITTLEコアの比率が高くなる。

ここで CPUFreq Governor とか OPP って何なのか調べてみる。

まず CPUFreq というのが一つの単語で、消費電力を抑えたりするために CPU の周波数を上げ下げする linux の仕組みらしい。で Governor は CPUFreq の要素とある。要素というのを Governor と Driver に分けているので、Driver が実体のことだとすると、Governor の方は周波数や電圧を動的に変更するアルゴリズムみたいなものだろうか。

What is CPUFreq?

CPUfreq is a linux kernel framework that monitors the performance requirements of a processor(s) and takes decisions to increase or decrease operating frequency in order to save power and/or reduce leakage power.

CpuFreq Architecture

CPUFreq consists two elements

The Governor - that makes decisions

The Driver - acts based on the decisions made by the governor

1. What Is A CPUFreq Governor?

==============================Most cpufreq drivers (except the intel_pstate and longrun) or even most

cpu frequency scaling algorithms only offer the CPU to be set to one

frequency. In order to offer dynamic frequency scaling, the cpufreq

core must be able to tell these drivers of a "target frequency". So

these specific drivers will be transformed to offer a "->target/target_index"

call instead of the existing "->setpolicy" call. For "longrun", all

stays the same, though.How to decide what frequency within the CPUfreq policy should be used?

That's done using "cpufreq governors".https://www.kernel.org/doc/Documentation/cpu-freq/governors.txt

以下も参考。

また OPP というのは Operating Performance Point の略で、DVFS で切り替える周波数と電力をペアにした単位のことのようだ。

1.1 What is an Operating Performance Point (OPP)?

Complex SoCs of today consists of a multiple sub-modules working in conjunction.

In an operational system executing varied use cases, not all modules in the SoC

need to function at their highest performing frequency all the time. To

facilitate this, sub-modules in a SoC are grouped into domains, allowing some

domains to run at lower voltage and frequency while other domains run at

voltage/frequency pairs that are higher.The set of discrete tuples consisting of frequency and voltage pairs that

the device will support per domain are called Operating Performance Points or

OPPs.

で、IKS のまとめとしては下記がしっくりくる。

LinaroのIKSは、CPU負荷に応じて2つのコアを切り替える。切り替えの遷移ポイントの決定には、負荷に応じてCPUコアの電圧と動作周波数を切り替える「DVFS(Dynamic Voltage and Frequency Scaling)」の仕組みを使ってる。Linuxの場合は、CPUFreq Governorと呼ばれるサブシステムがあり、CPU使用率をモニタしてCPUの動作周波数を遷移させる。IKSは、Governorからの情報で、DVFSが一定のポイントに達した時にCPUコアをスイッチさせる

【後藤弘茂のWeekly海外ニュース】海外のオクタコア版GALAXY S4の「big.LITTLE」ソフトウェアアーキテクチャ - PC Watch

長いので一旦ここで切ってつづく。

big.LITTLE の制御ソフトウェア技術を整理してみよう (その1)

http://pc.watch.impress.co.jp/docs/column/1month-kouza/20140626_655176.htmlpc.watch.impress.co.jp

上記の ARM の記事を見つけて、そこからいろいろたどってみたのだが、ARM の big.LITTLE の制御ソフトウェア技術(ユースモデル、ソフトモデルとも書かれている)の表記がいろいろ変わってわかりづらい。そこで Web の記事だけを拾って客観的に整理してみた。

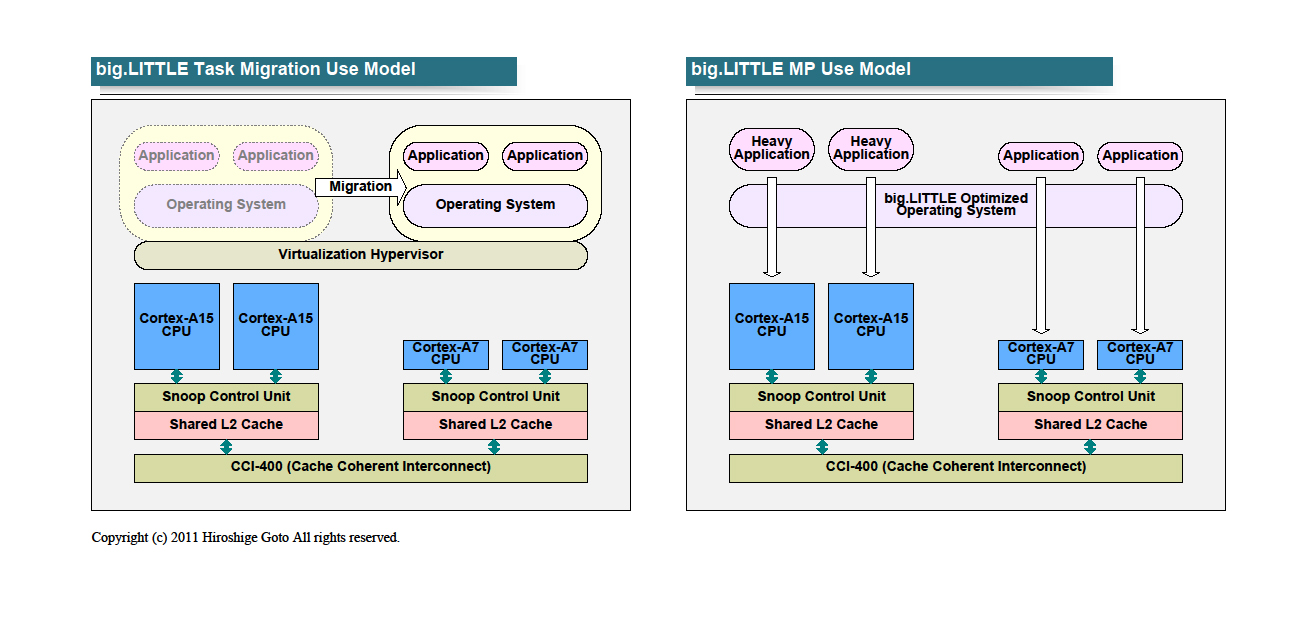

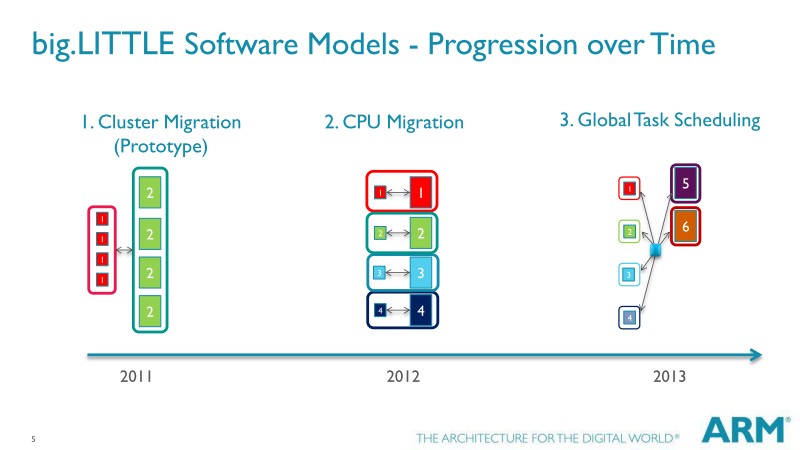

まず一番日付が古い 2011/11/30 の 【後藤弘茂のWeekly海外ニュース】ARMの新省電力技術big.LITTLEプロセッシング - PC Watch によると最初は2個で、

- Task Migration Use Model

- MP Use Model

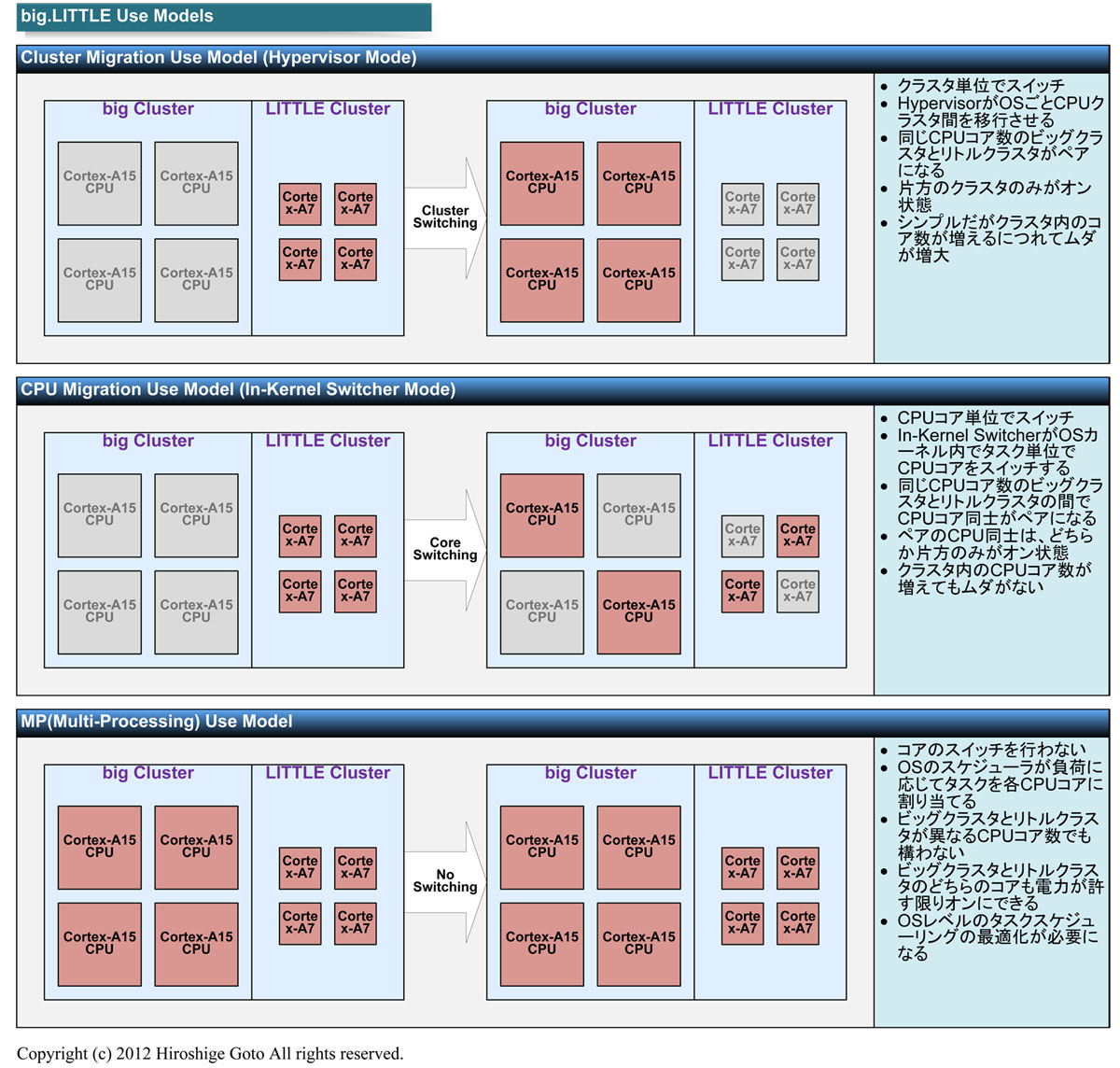

次に 2013/05/21 の 【後藤弘茂のWeekly海外ニュース】海外のオクタコア版GALAXY S4の「big.LITTLE」ソフトウェアアーキテクチャ - PC Watch によると、分類が3つになり、

- Cluster Migration Use Model (Hypervisor Mode)

- CPU Migration Use Model (In-Kernel Switcher Mode)

- MP (Multi-Processing) Use Model

続いて 2013/12/18 の 【後藤弘茂のWeekly海外ニュース】2014年にはメジャーになるARMの省電力技術「big.LITTLE」 - PC Watch および、2013/12/20 の 【後藤弘茂のWeekly海外ニュース】2014年のARMのSoCの中核技術となる「big.LITTLE MP」 - PC Watch では、3つ目が global task scheduling と呼ばれるようになり、MP は括弧の中に入った。

- Cluster Migration Use Model (Hypervisor Mode)

- CPU Migration Use Model (In-Kernel Switcher Mode)

- Global Task Scheduling (big.LITTLE MP)

さらに最近の 2015/11/28 の 【後藤弘茂のWeekly海外ニュース】Cortex-Aファミリーのダイエリアの変化から見えてくる次世代ARM CPU「Artemis」 - PC Watch では Heterogeneous がついた。

- Cluster Migration Use Model (Hypervisor Mode)

- CPU Migration Use Model (In-Kernel Switcher Mode)

- Global Task Scheduling (Heterogeneous Multi-processing)

経緯を拾っていくと、Cluster Migration Use Model は Task Migration Use Model の名称が変わったもの。

しかし、その後、ARMは路線を変更した。2012年秋の同社のカンファレンス「ARM Techcon」では、タスクマイグレーションと呼んでいたモデルを「クラスタマイグレーションモデル(Cluster Migration Model)」に名称変更。その上で、クラスタマイグレーションはプロトタイプのみで終わり、実際の製品向けには提供されないことになった。

【後藤弘茂のWeekly海外ニュース】海外のオクタコア版GALAXY S4の「big.LITTLE」ソフトウェアアーキテクチャ - PC Watch

また、技術の名前かソフトの名前か、Linaro が実装するか ARM が実装するか、で同じものでも呼び名が別になっている様子。

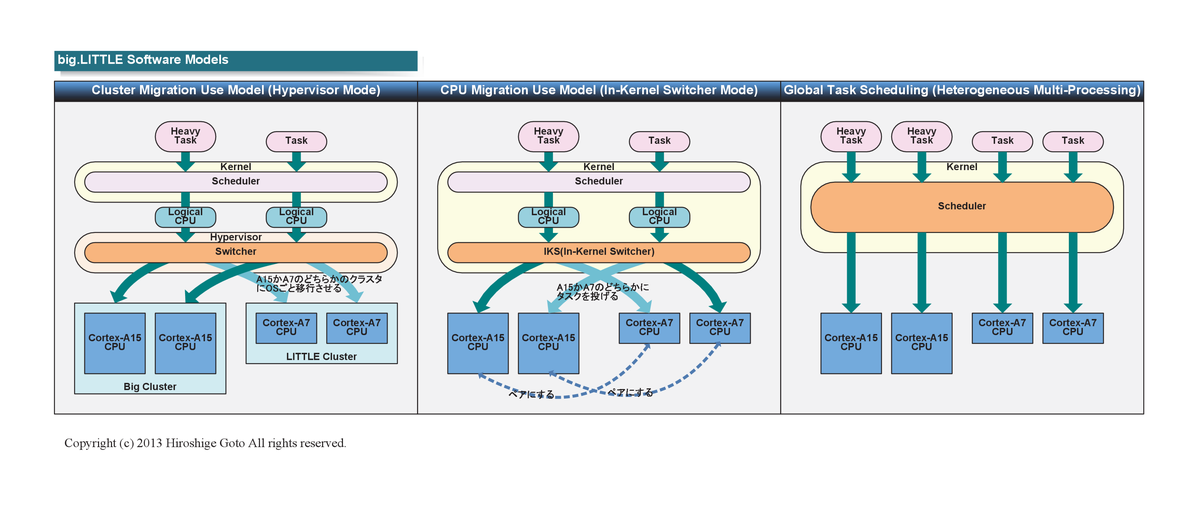

ここで用語を整理しておくと、Linaroの「big.LITTLE In-Kernel Switcher(IKS)」とARMの「big.LITTLE CPU Migration」は全く同じものだ。それに対して、big.LITTLEのCPUコアをOSスケジューラで効率的に使う技術自体のARMでの名称が「Global Task Scheduling(GTS)」。そして、GTSのARMでの実装が「big.LITTLE MP」パッチセットとなっている。また、big.LITTLE MPは、Linaroでは一時「Heterogeneous MP(HMP)」と呼ばれていた。さらに、現在Linuxコミュニティで議論されている、big.LITTLE対応も含む電力対応タスクスケジューラは「Power-Aware Scheduler」などと呼ばれている。

【後藤弘茂のWeekly海外ニュース】2014年にはメジャーになるARMの省電力技術「big.LITTLE」 - PC Watch

ARMベースSoC(System on a Chip)の省電力技術「big.LITTLE」。big.LITTLEでは、現在、2種類のソフトウェアモデルが提供されている。1つは、Linaro(ARMベースのLinuxコアテクノロジの共同開発のための非営利エンジニアリング組織)が開発した「big.LITTLE In-Kernel Switcher(IKS)」。これは「big.LITTLE CPU Migration」とも呼ばれる。

もう1つは、ARMが開発した「big.LITTLE MP」で、「Heterogeneous MP(HMP)」とも呼ばれる。ヘテロジニアスな構成のCPUコアを、拡張したOSスケジューラで使う技術コンセプト「Global Task Scheduling(GTS)」の現在の実装のパッチセットがbig.LITTLE MPだ。前者はLinaro、後者はARMで、しかも両者でそれぞれの呼び方が異なるためやや混乱しがちになっている。

【後藤弘茂のWeekly海外ニュース】2014年のARMのSoCの中核技術となる「big.LITTLE MP」 - PC Watch

またこちらを見ると

What’s the difference between "Global Task Scheduling" and "big.LITTLE MP"?

Global task scheduling is the technique of using all cores under control of the scheduler. The big.LITTLE MP patchset is a set of ARM-developed scheduler enhancement that implements the GTS technique.

とある。上の記事はこれの和訳に近いかも。

OR を取るとこんな感じ。

- Cluster Migration Use Model

- Hypervisor Mode

- 旧名は Task Migration Use Model

- CPU Migration Use Model

- Linaro は In-Kernel Switcher (IKS) Mode と呼ぶ

- MP (Multi-Processing) Use Model

ところで ARM TechCon 2015 という ARM のイベントでこの辺の最新状況が話された様子。

- Session Not Found | ARM TechCon 2016 Schedule

- ARM TechCon 2015 Schedule – IoT, Servers, 64-bit ARM, Power Usage Optimization, and More

このイベントの直接の資料は見つからないが、探してみると似たようなイベントが台湾であり、同じタイトルでそこには資料が置かれていた。

この p.17 を見ると、

という感じで MP Use Model の技術がさらに進化している様子がわかる。

以上、まずは用語を整理してみた。つづく。

書評とまとめ - 人工知能は人間を超えるか ディープラーニングの先にあるもの

バズワードと呼ばれるほど盛り上がっている人工知能。その鍵となるディープラーニング。著者は実力以上のブームに警鐘を鳴らす一方で、本のタイトルである「人工知能は人間を超えるのか」に対して次のように答えている。

人工知能は人間を超えるのか。答えはイエスだ。

もしかすると自分が生きているうちにそんな時代が来るのかもしれない。

- 作者: 松尾豊

- 出版社/メーカー: KADOKAWA / 中経出版

- 発売日: 2015/03/10

- メディア: Kindle版

- この商品を含むブログ (31件) を見る

最近の人工知能について知りたければまずはこの本からというレビューが目立つだけあって確かにわかりやすい。前半は機械学習やニューラルネットの歴史を踏まえながら今のディープラーニングに至るまでの技術的な説明。後半は我々社会への影響と今後の課題および熱いメッセージだ。

まずはブームに警鐘を鳴らす方の冷めた部分の整理から。

ちょうどこの本を読んでいる時と同じタイミングで以下の3つの記事を読んだ。世界トップレベルの技術をもってしても、ドローンは着地すらできないし、ロボットが攻めてきてもドアを閉めれば十分で、ネズミにも昆虫にも勝てないレベルらしい。

- 大西 宏のマーケティング・エッセンス : ロケットは無事帰還着地できても、ドローンの着地は案外難しい

- ロボットの王道はヒューマノイド型にあらず | On Off and Beyond

- 知能と技術的特異点 - Sideswipe

また、産総研イベントでも次のように言っている。

今の人工知能ブームについて、1980年代の第2次ニューロブームのときのことを思い出さざるを得ないと述べて、これまでの人工知能研究の歴史を振り返り、警告を発した。今の人工知能技術の基礎はいずれも当時出てきたもので、そこから本質的な飛躍はないという。

【森山和道の「ヒトと機械の境界面」】しなやかに人間によりそえる人工知能を ~産総研 人工知能研究センター(AIRC)始動へ - PC Watch

それでもなぜディープラーニングにここまで期待が集まるのか。著者は次のようにまとめていた。

人工知能の60年に及ぶ研究で、いくつもの難問にぶつかってきたが、それらは「特徴表現の獲得」という問題に集約できること。そして、その問題がディープラーニングという特徴表現学習の方法によって、一部、解かれつつあること。特徴表現学習の研究が進めば、いままでの人工知能の研究成果とあわせて、高い認識能力や予測能力、行動能力、概念獲得能力、言語能力を持つ知能が実現する可能性があること。そのことは、大きな産業的インパクトも与えるであろうこと。知能と生命は別の話であり、人工知能が暴走し人類を脅かすような未来は来ないこと。それより、軍事応用や産業上の独占などのほうが脅威であること。そして、日本には、技術と人材の土台があり、勝てるチャンスがあること。

続いてディープラーニングの技術面。ネットにはいろんなレベルの解説があるが、この本を読んで、要はこれまで特徴量だけは手動で決めていたのを、自動で獲得できるようになったことが一番のブレークスルーだと言ってよいことがわかった。

本書からいくつかポイントを拾ってみる。

ディープラーニングが従来の機械学習とは大きく異なる点が2点ある。1つは、1層ずつ階層ごとに学習していく点、もう1つは、自己符号化器(オートエンコーダー)という「情報圧縮器」を用いることだ。

そのためにどういうことをやるかというと、一見すると逆説的だが、入力信号に「ノイズ」を加えるのだ。

たとえば、ドロップアウトといって、ニューラルネットワークのニューロンを一部停止させる。

画像認識の精度が上がらなかったのは、頑健性を高めるためにいじめ抜くという作業の重要性(専門的に言うと、正則化のための新しい方法)に気づいていなかったため、そして、そもそもマシンパワーが不足してできなかったためである。

実際、多くの研究者が考えていた「自己符号化器をベースに特徴量を多段にしていけばよい」という予想は正しかったのである

自己符号化器と主成分分析にはいくつか違いがある。まず、自己符号化器の場合には、非線形な関数を用いている(というより、任意の関数を用いることができる)。2つ目は、主成分分析では通常、第二主成分は第一主成分の残余から計算されるので、第一主成分の影響を強く受ける。第三主成分は、第一、第二主成分の影響を強く受ける。したがって、高次の主成分になると、ほとんど実質的な意味がなくなってくる。

いまディープラーニングで起こりつつあることは、「世界の特徴量を見つけ特徴表現を学習する」ことであり

この事前に教師なし学習で特徴量を学習することを pre-training と呼び、pre-training の結果を用いて全体で教師ありで学習すること fine-tuning と呼んでいるようだ。

その他参考

私の pre-training の理解をまとめるとこんな感じ。

- 入力データの集合を再現できるように教師なし学習で特徴量を学習すること。本書では「教師あり学習的な方法による教師なし学習」と表現していた。

- 1層ずつ階層ごとに学習していく点と autoencoder (自己符号化器) で入力と出力が同じになるように学習(パラ―メータの調整)する点がポイント。

- 入力信号に「ノイズ」を加えて頑健性を上げる。

- ドロップアウト (過学習を防ぐため、隠れ層のパラメータをランダムに使わないようにして学習する) が精度に貢献している。

(2015/12/20 追記)

1層ずつ学習していくというのはこちらがわかりやすい。これによって gradient vanishing 問題を回避するとある。

また、autoencoder についてはこちらに1万円札を渡して1万円札をうけとるようなものという表現がされていてそんなイメージ。

「1万円札をお店の人に渡して、1万円札をうけとるようなもの」(「考える脳 考えるコンピュータ」J.Hawkins)

http://www.gdep.jp/seminar/20150526/DLF2015-01-MATSUO.pdf

一方で、これだけ盛り上がってしかも結果も出ているにも関わらず、ディープラーニングにはまだまだ解明できていない部分があるらしい。

冒頭に述べたような圧倒的な性能を示した深層学習ではあるが,課題は山積している.

まず,理論面的に解明されていない部分が数多くある.pre-trainingを採用したことによる誤差はどれくらいか?他にも効率のよい学習法はあるのか?pre-trainingが特徴の学習であるとするならば,既存の非線形次元削減や特徴生成とは何が違ったのか?その違いの本質が解明されれ,大規模データとそれにみあう複雑度のモデルが扱うことが可能であるならば,ニューラルネット以外でも深層学習と同等のモデルが獲得できるのか?

一方で,実用面でも,現状では調整すべきパラメータが多く性能を発揮するには忍耐強い調整を必要とするともいわれている.複雑なモデルの獲得には,大規模データを処理できることが必須となるが,並列計算手法の改良はまだまだ必要であろう.

人工知能学会誌 連載解説「Deep Learning(深層学習)」 | 人工知能学会 (The Japanese Society for Artificial Intelligence)

先の産総研のイベントのページでも以下のように言っていて、正直課題は昔と大きく変わっていない。

川人氏は、ニューラルネットワーク学習の最大の困難は、オーバーフィッティング、汎化能力の欠如、次元の呪いだと改めて指摘した

それでも前に前進していることには変わりない。本の後半で著者が述べているのは今後アカデミア(研究・オープン)とインダストリー(企業・ビジネス)のバランスが大事だということだと思う。

逆に言うと、特徴表現学習の部分を特定の企業に握られたり、ブラックボックス化されたりすると、非常にやっかいなことになる。特徴表現学習のアルゴリズムがオープンにならず、「学習済み」の製品だけが製造・販売されることになると、リバースエンジニアリングで分解したり動作を解析したりして仕様や仕組みを明らかにすることが不可能である。

パソコン時代にOSをマイクロソフトに、CPUをインテルに握られて、日本のメーカーが苦しんだように、人工知能の分野でも、同じことが起きかねない。

現在、ディープラーニングに代表される特徴表現学習の研究は、まだアルゴリズムの開発競争の段階である。ところが、この段階を越えると、今度はデータを大量に持っているところほど有利な世界になるはずだ。そうなると、日本はおそらく海外のデータを持っている企業に太刀打ちできない。世界的なプラットフォーム企業が存在しないからだ。

IoT およびそれに伴うビックデータというもう一つのブームと合わさって「ビックデータx人工知能」は今後のテーマとなる。繰り返しだが、もしかすると生きているうちにそんな時代が来るのかもしれない。今がその転換の最中なんだろうか。

dマガジンの今後の行方は要ウオッチ

ケータイ変えたときに強制的に加入することになったドコモのdマガジンが結構いいので継続したままにしている。月額400円で雑誌160誌が読み放題のサービス(2015/11/24現在)。

結構いいというのは、きっとこういうサービスでなければ手に取ることがなかったファッション誌やグルメ雑誌をぱらぱらとめくるのが結構楽しいのと、スタッフおすすめ記事という形で提供される雑誌間をまたいだ記事の直リンクへのまとめがトレンドを知るのに便利だからだ。今だと下町ロケットとか、パリ同時多発テロ事件とかディズニー&USJ Xmas とか多くの雑誌で取り上げている特集記事を横断して読むことができる。ちょっと前は iPhone 6s 解説や福山結婚記事とか。同じネタを雑誌横断で読めるのは電子&読み放題ならでは。

リアル雑誌と比較して、電子版用に一部割愛されているが文句はないレベル*1。リアル雑誌を買っても隅から隅まで読むことはほぼのないので、気に入った記事だけを読んでゴミが残らないのはよい。

ビジネスモデルとしてはユーザーの読んだ割合に応じて出版社に配分される仕組みになっているらしい。

現在はユーザーの課金収入の55%を出版社へ配分し、雑誌あたりのユニークユーザー数(期間内の訪問者数のこと)に応じて毎月配分している

スマホで「雑誌読み放題」人気はどこまで? | 企業戦略 | 東洋経済オンライン | 新世代リーダーのためのビジネスサイト

8月で200万人とあるから、400円 x 200万 x 0.55 = 4.4億円/月。その160誌での分配だからそんなに大きな金額ではない。

システムはKADOKAWAグループで電子書籍ストアを手掛けるブックウォーカーに委託しているらしい。で、そのカドカワは儲かっているとある。カドカワは 45%側なんだろうか。

- カドカワ・ドワ Research Memo(5):電子書籍はdマガジンが伸長し好調が続く | 特集 - 株探ニュース

- カドカワ、第2四半期は営業益35億円…ゲーム黒字転換、アニメロサマーライブで7~9月ライブ事業が黒字に | Social Game Info

ドコモのいろんなサービスは強制加入&解約忘れで儲けているのではないかという不信感が少しあるが、400円はコストパフォーマンスがよい。今後400円がキープできるのか、儲からないということで1年後にはなくなるのか、専門誌などさらに取り込んで月額料金の高いコースをつくる方向に行くのか、割愛されたページが解除されていくのか、他の漫画読み放題などのサービスと統合したりするのか、もう少し見守りたいと思う。

書評 - 「ついていきたい」と思われるリーダーになる51の考え方

目から鱗みたいな考え方がたくさん書かれているわけではなく、そりゃそうだという当たり前な内容が多かったというのが感想だが、逆に言うとついていきたいリーダーというのは、普通に考えて人としてそっちの方ががいいだろうということを冷静にこなしている人だと思う。論理だけでなく情も含めてそっちのほうがいいという判断。

- 作者: 岩田松雄

- 出版社/メーカー: サンマーク出版

- 発売日: 2012/10/09

- メディア: 単行本(ソフトカバー)

- 購入: 5人 クリック: 77回

- この商品を含むブログ (15件) を見る

一般に、相手を理解するというのは、プレゼンやコミュニケーションの基本だが、それにも関連すると思う以下の言葉がこの本の中では一番印象に残った。

年功序列意識も薄くなった今どきのドライの発想でいえば、「先輩だろうが、後輩だろうが、そんなことは関係ない。正しい意見を採用するべきだ」と思うかもしれません。実際、そうしたほうがいい場面もあるでしょう。しかし、そうしないほうがいい場面もあるのです。

組織に対して大きな影響力を及ぼさないような案件であれば、それは天秤にかけるべきです。先輩の顔をつぶしてでも、正しい意見にこだわって組織の雰囲気を悪くするか。それとも、組織の雰囲気を守ろうとするのか。その判断がリーダーの腕の見せどころだと思うのです。

そしてもうひとつ、重要なのはお客様の立場に立ってみる、ということです。お客様とて、「いくらです」「はい、そうですか」というわけにはいかないこともあるでしょう。「これだけ頑張りました」「これだけ値引いてもらいました」と上司に報告をしたいと思うのです。だから、社内的に言い訳が立つような理屈を作ってあげることが大切になる。相手も会社員なのです。一緒にその理由を考えてあげなさい、と。

その他、ハイライトしたことば。

まず私が心がけていたのは、自信を持って意思決定できないときは、決定のタイミングを先に延ばすことでした。つまり、「今決定しない」ということを決定する。そして、どうしてもこの時点までに決めなければいけない、という時期を確認する。

(中略)

かっこいい意思決定なんてしなくていいのです。求められているのは、正しい意思決定なのですから。

人事だけは、迷ったらやらないと決める

ぜひ、「何か、困ったことはない?」と聞いてあげてください。それは「ついていきたい」と思われる、大事な言葉のひとつだと私は思っています。

「好きなこと」「得意なこと」「人のためになること」の三つの円が重なったことをミッションにするべき、と書きました

録画の CM 再生率は 15%

2015年11/14号 週刊ダイヤモンドの記事によると 15% とのこと。

調査では、全国1000世帯以上を対象にテレビの録画再生機に。専用のモニター機器を設置、テレビで録画再生された番組を、視聴者がどのように見ているかを詳細に探った。

しかし、ふたを開けてみれば、1時間の番組中に4回ある CM の再生率は全体の15%前後。業界内では、それまでは3割は CM を見ているとされていたものの、その半分しか実は再生されていなかったわけだ。

されに言えば、15%という数字はあくまで、録画番組を再生した世帯を分母にしている。

録画しても番組を再生していない世帯や録画すらしていない世帯を分母に含めれば、再生率はわずか2%にとどまる。

最近はすっ飛ばせないネット CM が増えてきたが、見たいものを無料で見るために見たくないものを添えるとか、それを見せないためにお金払うとか、やっぱり方向として素直じゃないと思う。

100年生きる私たちの価値観について

本を読んだ後はその感想をネットでチェックして解釈や気付きを振り返るようにしているが、ほぼ日の対談記事を見つけた。www.1101.com

著者のリンダさんの意見がメインというよりは、糸井重里さんがリンダさんを会話を進めるうちにどんどん引き込んでいる様がメインに思えた。いろいろうまいこと言うなーと思ったのでその辺の惹かれるコメントをメモ。

糸井

やっぱり、

ひとりでできることには限界があって。

チームでないとできないことが多すぎたんです。

糸井

それはとても美しい姿勢だと思うのですが、

ぼくら日本人は

もうすこし勤勉ではない人間なんですよ。

「ここにいるのはイヤだよね」ということが、

そこから動く大きな動機になる(笑)。

リンダ

なぜわたしがこれらの本を書いたかというと、

これからは、昔とおなじ生活を送っていては

暮らせなくなってきていると思うからなんです。

糸井

もともと企業は、

そういう利益にはならないことも

当然「やること」としてきたんです。

でもいまは、

まず「儲かるか儲からないか」をスタートにおく。

そういう流行にみんなが合わせるように

なってしまったんだと思っています

糸井

それは「法人」という言葉で考えたら、

すごくわかりやすいんですよ。

英語には「法人」という言い方があるのかは

わからないのですが、

ぼくは、この言葉が表すように

やっぱり企業も「人」なんだと思うんです。

地域や人々への貢献を

当然のこととしてやっている「人格」と

利益を出すことだけを考えている「人格」とを

くらべてみたら、

人々は前者の人格に引かれていくに決まっています。

糸井

一方で、

「伝統的である」ということには案外、

いまの行きづまった状況と共通するものが

あるんじゃないかとも感じます。

つまり、

ある時代に大きな影響力を及ぼした「伝統」って、

実はじゃまものだったんじゃないかって。